Recentemente, as notícias falsas se tornaram uma grande ameaça à sociedade humana. Informações falsas podem ser espalhadas rapidamente pelas mídias sociais e podem afetar a tomada de decisões. Além disso, é um desafio, mesmo para as recentes tecnologias de IA reconhecerem dados falsos. Um dos desenvolvimentos mais recentes na manipulação de dados é bem conhecido como “Deepfake”, Que se refere a a troca de rostos em imagens ou vídeos. Até agora, as técnicas de Deepfake foram aplicadas principalmente trocando rostos de celebridades em vídeos engraçados ou fazendo políticos dizendo discursos hilariantes. No entanto, muitas indústrias podem se beneficiar de aplicações de Deepfake, como o indústria cinematográfica Usando edição de vídeo avançada.

Como funcionam os deepfakes?

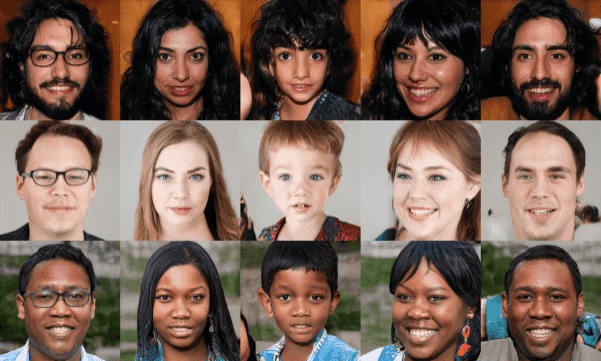

Vamos dar uma olhada mais de perto como os deepfakes funcionam. DeepFakes geralmente são baseados em Redes adversárias generativas (GANS)onde duas redes neurais concorrentes são treinadas em conjunto. Os Gans tiveram sucesso significativo em muitas tarefas de visão computacional. Eles foram apresentados em 2014 e arquiteturas modernas são capazes de gerar imagens de aparência realista que nem mesmo um humano não consegue reconhecer se é real ou não. Abaixo, você pode ver algumas imagens de um modelo GaN de sucesso chamado Stylegan.

Essas pessoas não são reais – elas foram produzidas por Stylegan’s gerador que permite o controle sobre diferentes aspectos da imagem.

O que é DeepFakes?

Baseado em wiki, DeepFakes são meios sintéticos em que Uma pessoa em uma imagem ou vídeo existente é substituída pela semelhança de outra pessoa. O ato de injetar uma pessoa falsa em uma imagem não é nova. No entanto, os métodos recentes do DeepFakes geralmente alavancam os recentes avanços de poderosos Ambos Modelos, com o objetivo de manipulação facial.

Em geral, a manipulação facial é geralmente realizada com os deepfakes e pode ser categorizada nas seguintes categorias:

-

Síntese facial

-

Troca de rosto

-

Atributos faciais e expressão

Síntese facial

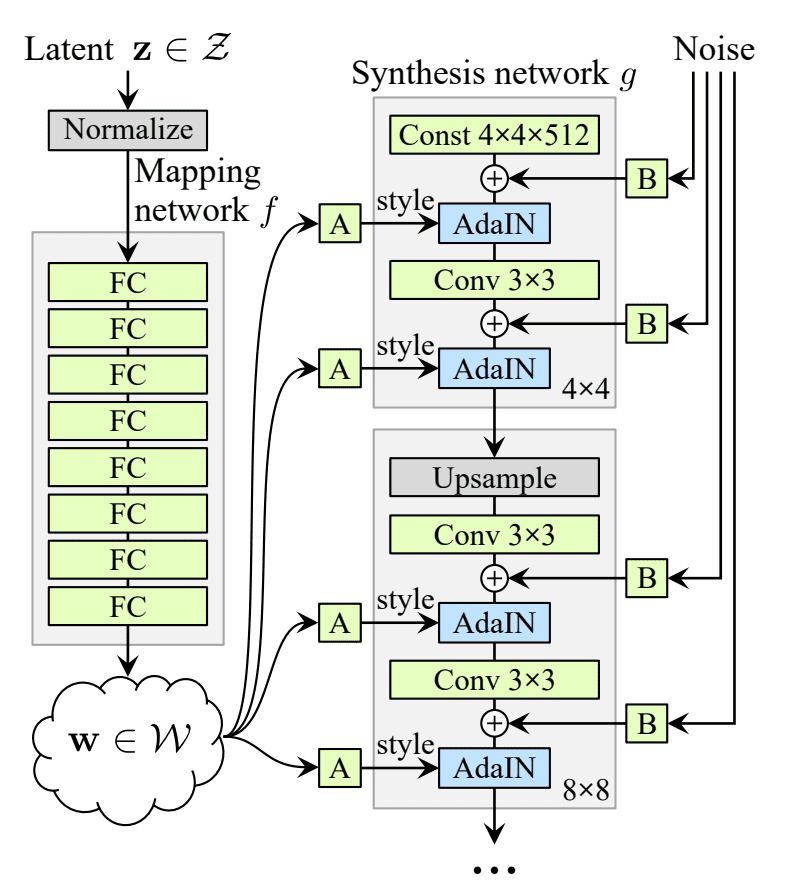

Nesta categoria, o objetivo é criar rostos realistas inexistentes usando Gans. A abordagem mais popular é Styegan. Resumidamente, uma nova arquitetura de geradores aprende a separação de atributos de alto nível (por exemplo, pose e identidade quando treinados em rostos humanos) sem supervisão e variação estocástica nas imagens geradas (por exemplo, sardas, cabelo) e permite o controle intuitivo e específico da síntese. O gerador do Stylegan é mostrado na Figura 2.

A entrada é mapeada através de várias camadas totalmente conectadas para uma representação intermediária c que é então alimentado a cada camada convolucional através da normalização da instância adaptativa (Adain), onde cada mapa de recursos é normalizado separadamente. O ruído gaussiano é adicionado após cada convolução. O benefício de adicionar ruído diretamente nos mapas de recursos de cada camada é que aspectos globais, como identidade e pose, não são afetados.

A arquitetura do generador de estilo órgão torna possível controlar a síntese de imagem via modificações específicas da escala para os estilos. A rede de mapeamento e as transformações afins são uma maneira de desenhar amostras para cada estilo de uma distribuição aprendida, e a rede de síntese é uma maneira de gerar uma imagem com base em uma coleção de estilos. Os efeitos de cada estilo estão localizados na redeou seja, modificar um subconjunto específico dos estilos pode afetar apenas certos aspectos da imagem. A razão para essa localização é baseada na operação de Adain que primeiro normaliza cada canal para zero média e variação unitária e só então aplica escalas e vieses com base no estilo. As novas estatísticas por canal, conforme ditado pelo estilo, modificam a importância relativa dos recursos para a operação de convolução subsequente, mas não depende das estatísticas originais devido à normalização. Assim, cada estilo controla apenas umConvolução antes de ser substituído pela próxima operação de Adain.

Arquitetura do gerador de Stylegan

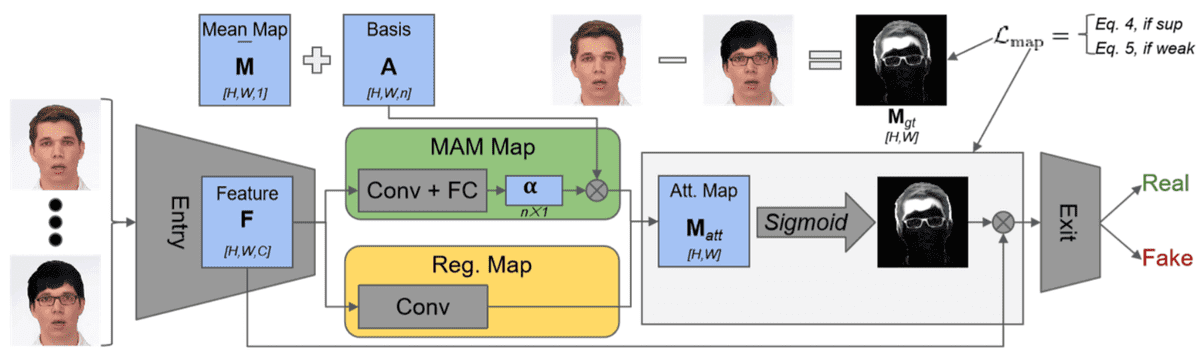

Para detectar imagens sintéticas falsas, várias abordagens foram produzidas. Por exemplo, no trabalho Sobre a detecção de manipulação de rosto digitalos autores usaram camadas de atenção em cima dos mapas de recursos para extrair as regiões manipuladas da face. A rede deles gera uma decisão binária sobre se uma imagem é real ou falsa.

O método de detecção de manipulação de face baseado em atenção.

A arquitetura da detecção de manipulação de rosto pode usar qualquer rede de backbone e a camada baseada em atenção pode ser inserida na rede. Ele pega o recurso de alta dimensão F de entrada, estima um mapa de atenção M_ATT usando métodos baseados em Manipulação (MAM) baseados em Modelo (MAM) e baseados em regressão, e o canal o multiplica com os recursos de alta dimensão, que são alimentados de volta na espinha dorsal. O método MAM assume que qualquer mapa manipulado pode ser representado como uma combinação linear de um conjunto de protótipos de mapa, enquanto o método de regressão estima o mapa de atenção por meio de uma operação convolucional. Além da perda de classificação binária, uma perda supervisionada ou fracamente supervisionada, o L_MAP pode ser aplicado para estimar o mapa de atenção, dependendo se o mapa de manipulação da verdade do solo está disponível.

Troca de rosto

A troca de rosto é a categoria de manipulação de rosto mais popular hoje em dia. O objetivo aqui é detectar se uma imagem ou vídeo de uma pessoa é falsa depois de trocar o rosto. O banco de dados mais popular com vídeos falsos e reais é FaceForensics ++. Os vídeos falsos neste conjunto de dados foram feitos usando gráficos de computador (FACESWAP) e métodos de aprendizado profundo (Deepfake Faceswap). O FACESWAP O App é escrito em Python e usa o alinhamento de rosto, a otimização de Gauss-Newton e a mistura de imagens para trocar a face de uma pessoa vista pela câmera com o rosto de uma pessoa em uma imagem fornecida. (Para mais detalhes, verifique o repositório oficial)

O Deepfake Faceswap A abordagem é baseada em dois autoencoders com um codificador compartilhado que são treinados para reconstruir imagens de treinamento da fonte e da face alvo, respectivamente.

Uma face em uma sequência de destino é substituída por uma face observada em um vídeo de origem ou coleção de imagens. Um detector de rosto é usado para cortar e alinhar as imagens. Para criar uma imagem falsa, o codificador treinado e o decodificador da face da fonte são aplicados à face do alvo. A saída do autoencoder é então misturada com o restante da imagem usando Edição de imagem de Poisson.

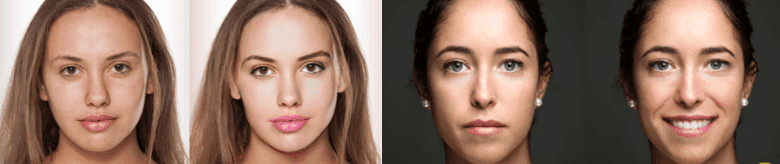

Exemplo de troca de rosto, tirada de aqui

A detecção de rostos trocados está agora evoluindo continuamente, pois é muito importante para proteger os direitos humanos. AWS, Facebook, Microsoft, o Parceria no Comitê Diretor de Integridade da Mídia da IAe acadêmicos se uniram para construir o Desafio Detecção de Deepfake (DFDC) em Kaggle com 1.000.000 $ prêmios no total. O objetivo do desafio é estimular pesquisadores em todo o mundo a construir novas tecnologias inovadoras que possam ajudar a detectar os deepfakes e a mídia manipulada. A maioria dos sistemas de detecção de troca de face usa redes neurais convolucionais (CNNs) tentando aprender recursos discriminativos ou reconhecer “impressões digitais” que são deixadas de imagens sintetizadas por Gan. Experiências extensas foram conduzidas de Rasler para. al com cinco arquiteturas de rede.

-

Um sistema baseado na CNN treinado através de recursos artesanais

-

Um sistema baseado na CNN com camadas de convolução que tentam suprimir o conteúdo de alto nível da imagem

-

Um sistema baseado na CNN com uma camada de pool global que calcula quatro estatísticas (média, variação, máximo e mínimo)

-

a CNN Mesoinception-4 Sistema de detecção

-

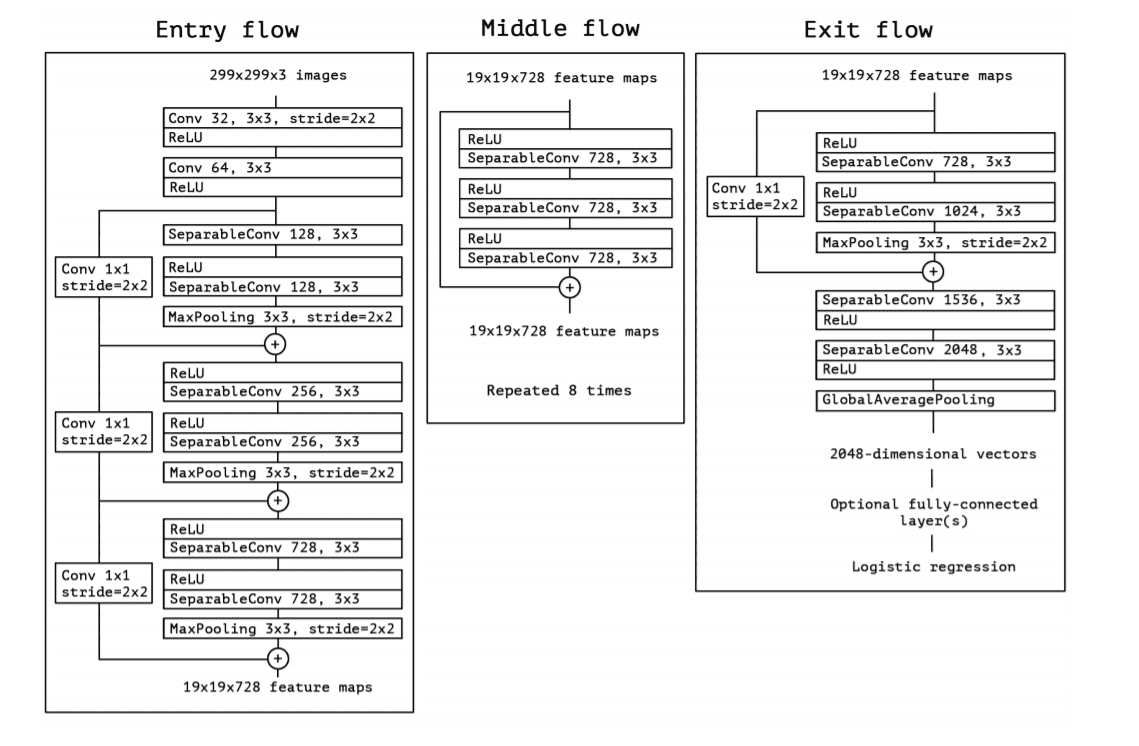

o sistema baseado na CNN XcendNet pré-treinado usando o conjunto de dados ImageNet e treinado novamente para a tarefa de troca de face. XceptionNet é uma arquitetura da CNN inspirada em Começo e usa convoluções separáveis em termos de profundidade

XcendNet alcançou os melhores resultados na detecção de troca de rosto entre essas cinco arquiteturas na detecção de imagens falsas. Sua superioridade no desempenho é fortemente baseada em Convidões profundas.

Arquitetura XceptionNet retirada do original trabalhar

Atributos faciais e expressão

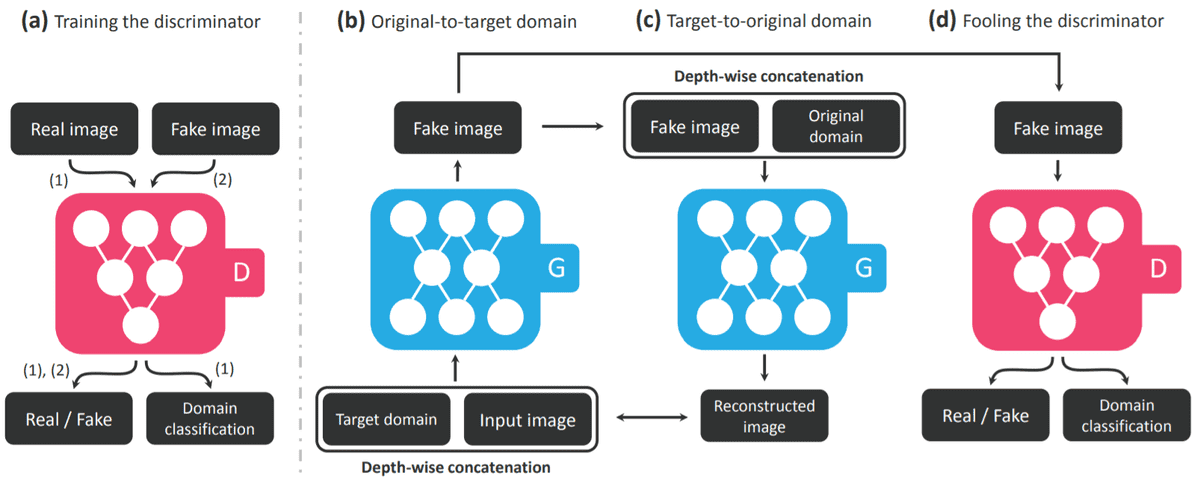

Os atributos faciais e a manipulação da expressão consistem em modificar atributos do rosto, como a cor do cabelo ou da pele, a idade, o sexo e a expressão do rosto, deixando -o feliz, triste ou zangado. O exemplo mais popular é o FaceApp Aplicativo móvel que foi lançado recentemente. A maioria dessas abordagens adota gans (o que mais?) Para tradução de imagem para imagem. Um dos métodos de melhor desempenho é Stargan que usa um único modelo treinado em vários domínios de vários atributos, em vez de treinar vários geradores para cada domínio. Uma análise detalhada é fornecida aqui.

Exemplo de manipulação de atributos faciais, emprestada de aqui

A arquitetura geral de Stargan, retirada do original trabalhar

O Stargan consiste em um discriminador D e um gerador G. O discriminador tenta prever se uma imagem de entrada é falsa ou real e classifica a imagem real em seu domínio correspondente. O gerador assume a entrada como a imagem e a etiqueta do domínio de destino e gera uma imagem falsa. O rótulo do domínio de destino é replicado e concatenado espacialmente com a imagem de entrada. Em seguida, o gerador tenta reconstruir a imagem original da imagem falsa, dada o rótulo de domínio original. Finalmente, o gerador G tenta gerar imagens indistinguíveis de imagens reais e classificáveis como domínio de destino pelo discriminador.

Finalmente, você pode assistir a este vídeo para maximizar seu entendimento:

https://www.youtube.com/watch?v=dckbrcuyop8

Conclusão

Neste artigo, motivado pelo recente desenvolvimento de métodos de geração e detecção de DeepFakes, Discutimos as principais abordagens de manipulação do rosto representativo. Para obter mais informações sobre conjuntos de dados DeepFakes, bem como métodos de geração e detecção, você pode conferir meu Repo Github. Tentamos coletar uma lista com curadoria de recursos em relação a DeepFakes.

Referências

-

Karras, T., Laine, S., & Aila, T. (2019). Uma arquitetura geradora baseada em estilo para redes adversárias generativas. Em Anais da conferência IEEE sobre visão computacional e reconhecimento de padrões (pp. 4401-4410).

-

Toulouse, R., Birth, R., Firm, J., Morals, A., & Orthlegate, J. (2020). DeepFakes e além: Uma pesquisa com manipulação de rosto e detecção falsa. Arxiv pré -impressão Arxiv: 2001.00179.

-

Chollet, F. (2017). Xception: Aprendizagem profunda com convoluções profundas separáveis. Em Anais da conferência IEEE sobre visão computacional e reconhecimento de padrões (pp. 1251-1258).

-

Choi, Y., Choi, M., Kim, M., Ha, JW, Kim, S., & Choo, J. (2018). Stargan: redes adversárias generativas unificadas para tradução para imagens para imagens de vários domínios. Em Anais da conferência IEEE sobre visão computacional e reconhecimento de padrões (pp. 8789-8797).

-

Goodfellow, I., Pouget-Abadie, J., Mirza, M., Xu, B., Warde-Farley, D., Ozair, S., … & Bengo, Y. (2014). Redes adversárias generativas. Em Avanços nos sistemas de processamento de informações neurais (pp. 2672-2680).

-

Afchar, D., Nozick, V., Yamagyshis, J., & Echizen, I. (2018, Deceiver). Mesonet: uma rede compacta de detecção de falsificação em vídeo facial. Em 2018 IEEE International Workshop sobre Informação Forense e Segurança (WIFs) (pp. 1-7). IEEE.

-

Rossler, A., Cozzolino, D., Verdoliva, L., Riess, C., Thies, J., & Nießner, M. (2019). FACEFORENSICS ++: Aprendendo a detectar imagens faciais manipuladas. Em Anais da Conferência Internacional do IEEE sobre Visão Computacional (pp. 1-11).

* Divulgação: Observe que alguns dos links acima podem ser links de afiliados e, sem nenhum custo adicional, ganharemos uma comissão se você decidir fazer uma compra depois de clicar. Solana Token Creator

Luis es un experto en Ciberseguridad, Computación en la Nube, Criptomonedas e Inteligencia Artificial. Con amplia experiencia en tecnología, su objetivo es compartir conocimientos prácticos para ayudar a los lectores a entender y aprovechar estas áreas digitales clave.